プレゼンテーション:松村 誠一郎

Maxを用いたインタラクティブサウンドインスタレーション事例の紹介

Maxは、プログラミング初心者でも容易にプログラムの流れや構造を理解することができるビジュアルプログラミング環境、という大きな特徴を持っている。一方、実際に作品を制作する側に立った場合、以下のような利点があると言える。

1. アイデアを即座に実現する、ラピッド・プロトタイピングに優れている。

2. 「もしこうしたら?」という実験的な試みや拡張を、プログラム(パッチ)を実行しながら試せる。

3. OSC(Open Sound Control)で他のプログラミング環境、ツールと通信ができる。

4. 使用可能なインターフェイスの種類が多い。

5. 音楽、音響の処理のためのオブジェクトが数多く用意されている。

上記のポイントのいくつかは、2018年現在ではProcessing、openFrameworks、Unity、Touch Designer等の他のプログラミング環境でも行なうことが可能である。しかし、設計思想の段階から現在に至るまで、

• プログラミングの対象が「音楽」や「音」、「映像」に特化している。

• 「プログラマー以外の人間がプログラミングを行えるようにする」

という前提を維持したまま、20年以上に渡って醸成されてきた開発環境としての Maxは独自の存在感を有していると言える。

筆者は1997年にOpcode社Maxを購入し、MSPが実装された後の2001年以降、音を軸とした鑑賞者参加型のインタラクティブアート作品を制作してきた。現在はMaxの兄弟分である同様のビジュアルプログラミング環境Pure Dataと状況に応じてMaxを使用している(Pure Dataは、Maxの開発に携わったMiller Puckette氏が開発、発表したオープンソースの開発環境である)。本稿では、Maxを使用した筆者のインタラクティブサウンドインスタレーションの作品事例を紹介する。

・Hop Step Junk(2004)

作品「Hop Step Junk」は、楽器音ではなく鑑賞者の「足音」や「接触音」という具体音(コンクレートサウンド)を一定時間録音してループ再生することによって、リズムパターンを鑑賞者自身が作ることを体験できる。

Fig.1 Hop Step Junk 全景

Fig.2 Hop Step Junk 展示風景

鑑賞者のインタラクションの手順は以下の通りである。

1. 左右の踏み台の上でステップを踏むと、最初のステップを検知して録音が開始される。

2. 一定時間経過後に録音を停止し、踏み台の横にあるスピーカーからモノラル音声としてループ再生音が出力される。

3. 音響の音量に応じたビジュアルが天井のプロジェクタから床面に投影され、リズム・パターンを視覚情報としても確認できる。

4. 左右の踏み台からそれぞれ入力されたリズム・パターンは、同じ時間のループ再生を行なって同期することで、両者の組み合わせによる新たなリズム・パターンが作られる。

音量に反応するビジュアルは数種類あり、一定時間ごとに切り替えられる。ビジュアルを切り替えるたびに、再生音にかかるディレイエフェクトのディレイ・タイムやフィードバック量のパラメータが変更される。

本作品は 2004 年に制作し、2005 年にフランス ラヴァルで開催されたLAVAL Virtual、 カナダ バンクーバーで開催されたNIME(New Interfaces for Musical Expression)05という国際会議で展示発表を行なった。また、2010年〜2016年には日本各地やアジアで開催された「魔法の美術館」展シリーズに定期的に出展した。

・Sound Wrinkle(音のしわ)(2016〜2017)

作品「Sound Wrinkle(音のしわ)」のコンセプトは「人の声の中に存在する、表現になりうる美的な要素を発見する」というものである。鑑賞者自身でマイクに録音をすると、その声がディプレイに声紋のようなスペクトラムとして表示される。鑑賞者自身が音の再生位置を示すプレイバーを左右に動かすことで、速度や再生方向を変えて再生したり、ある位置の音だけを鳴らして響きを確認することができる。バッファに録音した声のデータはFFTを用いて記録しており、再生にはiFFTを用いているので、声の高さ(ピッチ)を変更することなく滑らかな音の再生と変化を実現している。

Fig.3 渋谷ハチラボ(2016年)での展示風景

Fig.4 SMC2017の展示風景

Fig.5 Sound Wrinkle全景

2016年の初期バージョンと2017年のバージョンでの最大の違いはインターフェイスである。2016年のバージョンでは、MIDIコントローラ(KORG nanoKONTROL2)の必要な一部のみを露出したインターフェイスを使用して、鑑賞者のインタラクションで作品を稼働していた。その手順は以下の通りである。

1. 鑑賞者は録音ボタンを押して声をマイクに録音する。

2. ノブを回してプレイバーの位置を変更して再生音を聴く。

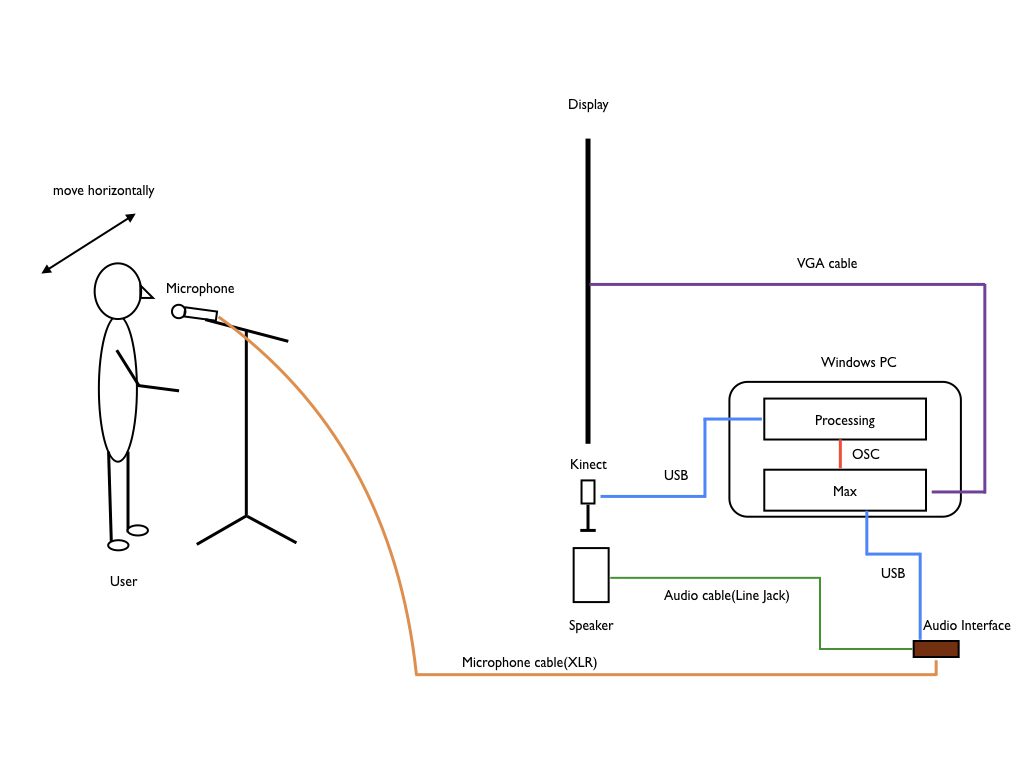

2017年のバージョンでは、Microsoft社Kinect Xbox ONE(Kinect2)をインターフェイスとして用いた。

1. 鑑賞者がマイクに向かって声を出すと、入力のゲインを感知して録音が開始する。3秒間の録音の後に停止する。

2. ディスプレイの前の一定の距離範囲で、身体を左右に動かしたり手を動かして、プレイバーの位置を変更して再生音を聴く。

Kinect2 による深度(奥行き)センサーの解像度は高く、微小な身体や手の動きによって 微細なコントロールが可能となっている。このインターフェイスにより、人間の身体が「テ ープヘッド」になってアナログテープを再生しているような感覚を演出できるようになった。Kincet2はMaxで認識できるオブジェクトが存在しないため、Kinect2からのデータの受け取りと検知した範囲の中心座標(Blob)の特定、すなわちトラッキングポイントの算出は Processingで行なっている。ProcessingからOSC経由でMaxへ、トラッキングポイントのX座標が送信された後、Maxではデータのスケーリングを経てプレイバーのコントロールパラメータに用いて音を再生する。スペクトログラムの表示はMaxが行なっている。

本作品は2016年に制作して渋谷こども科学センターハチラボで展示され、改良を加えて2017年にフィンランド ヘルシンキにて開催されたSound and Music Computing Conference(SMC2017)で展示発表した。

Fig.6 Sound Wrinkle構造図

ProcessingとMaxの役割分担を組み合わせた作品「Sound Wrinkle」のように、単独のプログラミング環境では実現が難しいことも、OSCによって複数の環境を組み合わせて実現している例は、現在のメディアデザイン案件では頻繁に見られる。しかし、いわゆる音楽の楽曲というのとも少し異なる、「音」そのものを素材にしてインタラクションを伴った表現を実現したい、しかも短時間で実現したい場合、音楽処理や音響処理とビジュアル インターフェイスに一日の⻑がある Maxを使うメリットがあると言えよう。また、インターフェイスについても、MIDI キーボード、MIDIコントローラ、Webカメラ、Arduino等のマイコンボードを経由した各種センサと接続して利用できるオブジェクトが用意されているため、実験的に試すことが可能である。

筆者の制作するサウンドインスタレーションの共通するコンセプトは、「音楽の訓練を受けていない人でも、作品の体験を通して楽しみながら音の表現につながるアウトプットを出せる」ことである。その際にインタラクションを構成するユーザーインターフェイス部分を、容易に試すことができるアドバンテージは大きい。技術的な手続きや障壁が軽減されると、それだけ作品のコンセプトや意義の構築により集中できることにつながっていく。このポイントゆえに、筆者は作品制作の手段としてMaxを使用しているのだと言える。

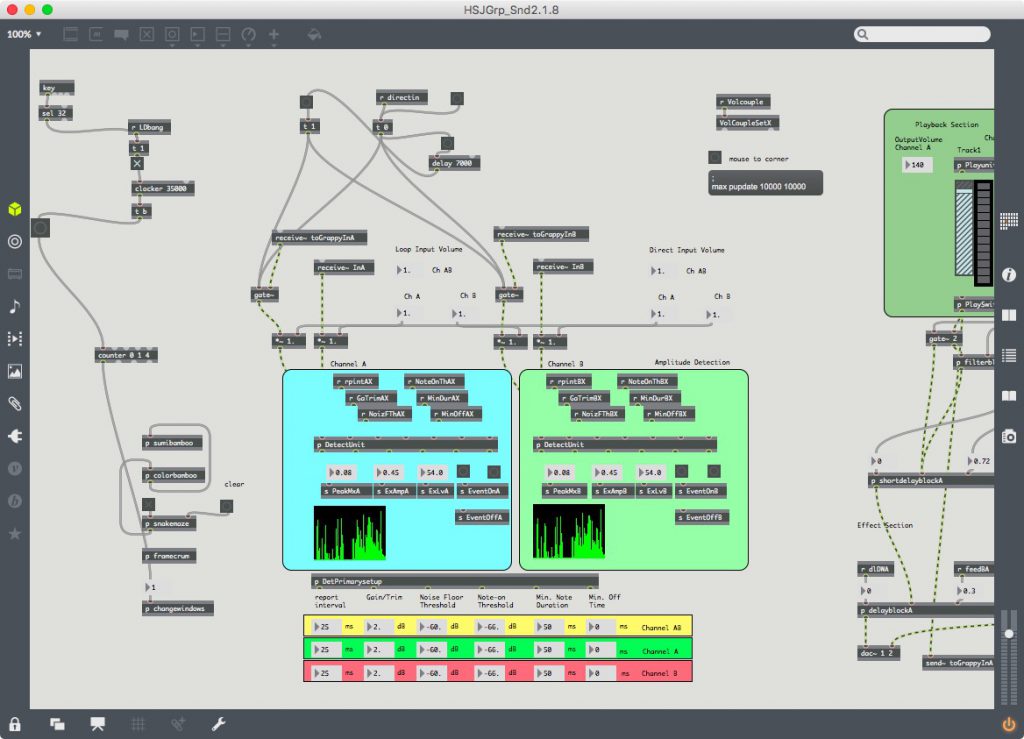

Hop Step Junk Maxパッチ

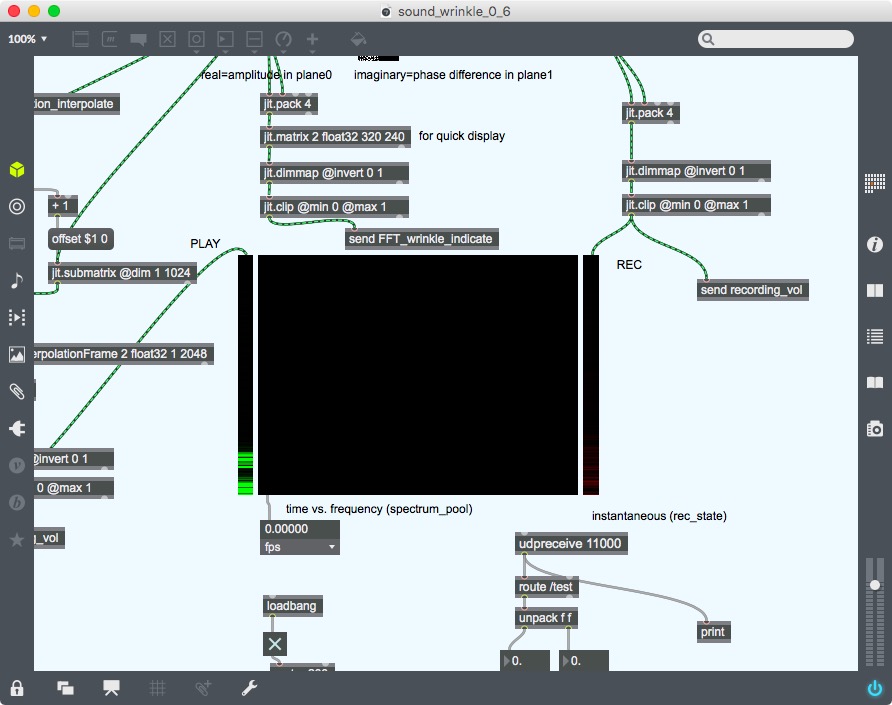

Sound Wrinkle Maxパッチ

松村 誠一郎 Seiichiro Matsumura

ゲーム会社にてサウンドデザイナーとしてアーケードゲーム制作業務に携わった後、2001年よりインタラクティブアート作品の制作を開始する。一貫して音と映像そしてインタラクションを軸にした、「競わない遊び場」の創出を目指して制作を続けてきている。作品はNIME、Sound and Music Computing等の国際学会、WRO Media Art Biennale、Audio Art等のアートフェスティバルをはじめ、国内外において展示発表される。アジアデジタルアート大賞をはじめ、受賞多数。

著書に「Pd Recipe Book -Pure Dataではじめるサウンドプログラミング」(BNN 新社)、 「『Max』ではじめるサウンドプログラミング」(工学社)がある。 現在、東京工科大学デザイン学部教授。博士(学際情報学)。

Webサイト:low-tech-ism.com

English

English